Đáng chú ý hơn, trong khi có tốc độ vượt trội so với các mô hình AI dựa trên ngôn ngữ lớn truyền thống, mô hình AI mới của Trung Quốc hoàn toàn dựa trên các chip AI do công ty Trung Quốc tự phát triển.

Các nhà nghiên cứu tại Viện Tự động hóa thuộc Viện Hàn lâm Khoa học Trung Quốc ở Bắc Kinh vừa giới thiệu một hệ thống trí tuệ nhân tạo mang tính đột phá mang tên SpikingBrain 1.0. Đây được nhóm nghiên cứu mô tả là mô hình ngôn ngữ lớn "giống như não người", được thiết kế để sử dụng ít năng lượng hơn và hoạt động trên phần cứng do Trung Quốc sản xuất thay vì phụ thuộc vào chip của công ty dẫn đầu ngành Nvidia.

Theo nhóm nghiên cứu, các mô hình ngôn ngữ lớn dựa trên Transformer chính thống - ví dụ như ChatGPT - đang phải đối mặt với những thách thức đáng kể về hiệu suất. Cụ thể, việc tính toán trong quá trình huấn luyện tăng theo cấp số nhân với độ dài chuỗi, trong khi bộ nhớ suy luận lại tăng tuyến tính. Đây chính là những rào cản mà SpikingBrain 1.0 hướng tới giải quyết.

Nền tảng AI mới SpikingBrain 1.0 do Trung Quốc phát triển được cho có tốc độ xử lý nhanh vượt trội so với ChatGPT, có thể gấp hơn 100 lần đối với các tác vụ phức tạp

Kết quả thử nghiệm cho thấy SpikingBrain 1.0 thực hiện một số tác vụ nhanh hơn tới 100 lần so với các mô hình thông thường, đồng thời chỉ cần được huấn luyện trên ít hơn 2% lượng dữ liệu thường yêu cầu. Dự án này là một phần trong nỗ lực khoa học lớn hơn về tính toán neuromorphic, nhằm tái tạo hiệu suất đáng kinh ngạc của não người với mức tiêu thụ năng lượng chỉ khoảng 20 watt.

Công nghệ cốt lõi đằng sau SpikingBrain 1.0 được gọi là "tính toán xung", một phương pháp bắt chước cách thức hoạt động của các tế bào thần kinh sinh học trong não người. Thay vì kích hoạt toàn bộ mạng lưới rộng lớn để xử lý thông tin như các công cụ AI chính thống kiểu ChatGPT, mạng lưới của SpikingBrain 1.0 hầu hết thời gian ở trạng thái yên tĩnh. Hệ thống sử dụng cách tiếp cận dựa trên sự kiện, trong đó các tế bào thần kinh chỉ phát tín hiệu khi được kích hoạt cụ thể bởi đầu vào.

Phản ứng có tính chọn lọc này chính là chìa khóa giúp giảm tiêu thụ năng lượng và rút ngắn thời gian xử lý. Để chứng minh khái niệm của mình, nhóm nghiên cứu đã xây dựng và thử nghiệm hai phiên bản của mô hình: phiên bản nhỏ hơn với 7 tỷ tham số và phiên bản lớn hơn chứa 76 tỷ tham số. Cả hai đều được huấn luyện bằng tổng cộng khoảng 150 tỷ token dữ liệu, một lượng tương đối nhỏ cho các mô hình ở quy mô này.

Hiệu suất của mô hình đặc biệt nổi bật khi xử lý các chuỗi dữ liệu dài. Trong một bài kiểm tra được trích dẫn trong nghiên cứu, mô hình nhỏ hơn phản hồi một lời nhắc gồm 4 triệu token nhanh hơn hơn 100 lần so với hệ thống tiêu chuẩn. Trong một thử nghiệm khác, một biến thể của SpikingBrain 1.0 đã thể hiện tốc độ nhanh gấp 26,5 lần so với kiến trúc Transformer thông thường khi tạo ra chỉ token đầu tiên từ ngữ cảnh một triệu token.

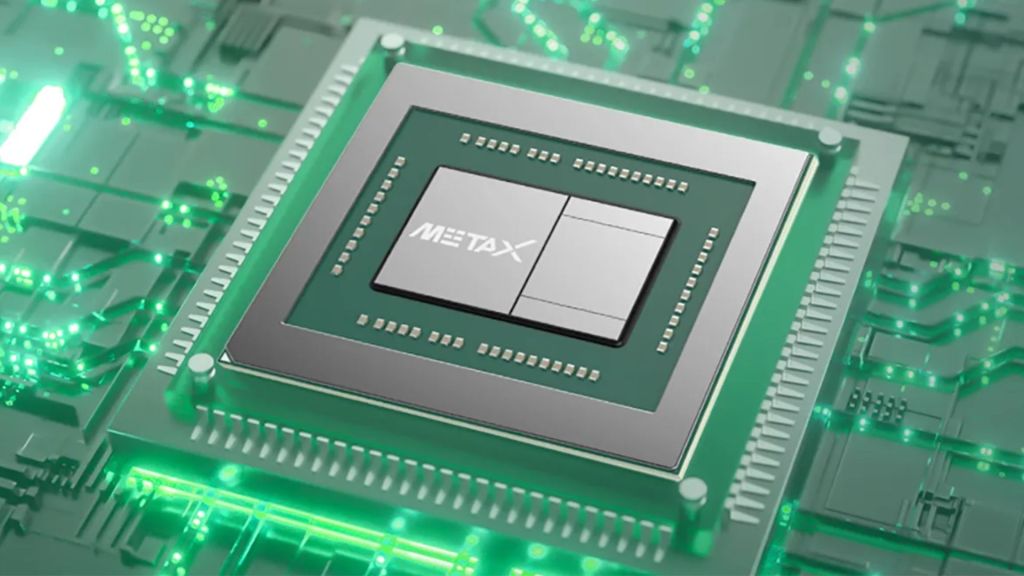

Nền tảng AI mới được xây dựng dựa trên các chip MetaX do công ty Trung Quốc tự phát triển

Các nhà nghiên cứu báo cáo rằng hệ thống của họ hoạt động ổn định trong nhiều tuần trên thiết lập hàng trăm chip MetaX, một nền tảng được phát triển bởi công ty MetaX Integrated Circuits Co có trụ sở tại Thượng Hải. Hiệu suất bền bỉ trên phần cứng trong nước nhấn mạnh tiềm năng triển khai thực tế của hệ thống.

Những ứng dụng tiềm năng này bao gồm phân tích các tài liệu pháp lý và y tế dài, nghiên cứu vật lý năng lượng cao, và các tác vụ phức tạp như giải trình tự DNA - tất cả đều liên quan đến việc hiểu các bộ dữ liệu khổng lồ nơi tốc độ và hiệu quả là yếu tố then chốt.

Như nhóm nghiên cứu kết luận trong bài báo khoa học của họ, những kết quả này không chỉ chứng minh tính khả thi của việc huấn luyện mô hình lớn hiệu quả trên các nền tảng không phải NVIDIA, mà còn phác thảo những hướng mới cho việc triển khai có thể mở rộng và ứng dụng các mô hình lấy cảm hứng từ não bộ trong các hệ thống tính toán tương lai.